使用苹果设备的朋友都知道,苹果的Siri助手的工作方式是接收到用户的命令,然后将收到的语音匿名发送至苹果公司服务器上,经过语音转换成文本,再对用户发出的指令进行解释,并将结果发送至iPhone和iPad上,而这个过程的语音识别工作非常复杂,需要在苹果公司的服务器上完成,因此iPhone系列的设备未必能够胜任。

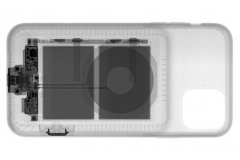

苹果为Siri考虑离线模式(图片来自网络)

对于Siri来说,依赖服务器就意味着如果没有网络连接,这款虚拟助手就无法工作,尽管“Hey Siri”仍然会触发该服务,却只能显示离线消息。苹果周四发布的专利申请文件“离线个人助理”显示,这一情况未来可能会发生变化。

根据文件显示,不用连接到苹果公司的服务器,语音到文本的处理和验证将在设备上完成。在听到用户发出请求时,设备将能够通过机载自然语言处理功能来确定任务,如果所请求的任务是有用的,则进行计算,然后执行。苹果公司表示使用设备上的机载系统处理未联网时的数字助理请求。它包含了语音合成、对话处理、基于默认词汇表以及用户创建数据的语音-字母转换和自然语言处理等模块。根据识别的单词和查询的结构,离线数字助理可以执行存储在任务流处理模块或服务处理模块中的多个预定义任务。这两个存储包含常用请求的模型,例如设置计时器或播放保存在设备中的歌曲,并根据请求执行相应的任务模型。在申请中,苹果公司表示使用了机器学习机制来执行特定类型的任务,包括自然语言处理。

这对于系统理解上下文信息,在不联网的情况下,基于非常有限的机载数据理解用户想要什么非常有帮助。即使有了针对离线场景的机载处理功能,如果连接可用,仍然建议保持联机。该系统可以根据连接的可用性,以两种不同的方式工作。访问本地和远程处理还将为数字助理提供对用户语音的两种可能的解释。在这种情况下,系统会对两种解释评定有用性分数,然后执行得分较高的一个。

这将有效地为助手提供备选项,如果本地执行的处理无法得到有用的结果,可以将服务器处理的结果作为备用。如果服务器版本超时或者不可用,本地版本仍然可以完成任务。通常,苹果公司每周都会申请很多专利,虽然专利申请中描述的概念确实表明了苹果公司感兴趣的领域,但并不能保证此类系统将来一定会出现在该公司未来的产品之中。对于离线Siri来说,苹果走这条路似乎是相当合理的。在最近发布的iPhone中,A系列处理器包含了神经引擎,该引擎用于执行计算密集型任务,如面部识别身份验证和与拍照相关功能供电,但它也可被用于执行机器学习的任务。考虑到2018年iPhone版本中使用的第二代神经引擎的强大功能,离线Siri完全有可能利用强大的功能和机器学习能力来执行离线处理。离线模式并不是苹果公司改进Siri的唯一方式,它已经采用了许多不同的概念以使数字助理变得更好。

10月份的一项专利说明了Siri如何通过“声纹”识别特定用户,同时苹果公司也在努力通过个性化响应实现多用户支持。Siri已经完成了一些与识别能力有关的改进,包括地理语音模型——帮助解决区域查询和方言口音问题。消费者更清楚的是在iOS 12中引入了Siri Shortcuts,它允许用户制作他们专属的个人Siri命令。

文章来源:手机中国 相关文章

相关文章

精彩导读

精彩导读

热门资讯

热门资讯 关注我们

关注我们